【新进展】知识图谱+大模型-->医疗诊断

在当今的医疗保健中,电子健康记录(EHRs)和日常文档记录对患者的护理至关重要。EHRs提供了患者的全面健康信息,包括病史、诊断和治疗。然而,由于EHR叙述内容繁多且复杂,容易导致医疗人员信息过载,进而增加诊断错误的风险。近年来,生成式大型语言模型(LLMs)在各类语言任务中的表现令人瞩目,但在医疗领域的应用面临诸多挑战,尤其是在减少诊断错误和避免对患者造成伤害方面。

背景与意义

在当今的医疗保健中,电子健康记录(EHRs)和日常文档记录对患者的护理至关重要。EHRs提供了患者的全面健康信息,包括病史、诊断和治疗。然而,由于EHR叙述内容繁多且复杂,容易导致医疗人员信息过载,进而增加诊断错误的风险。近年来,生成式大型语言模型(LLMs)在各类语言任务中的表现令人瞩目,但在医疗领域的应用面临诸多挑战,尤其是在减少诊断错误和避免对患者造成伤害方面。

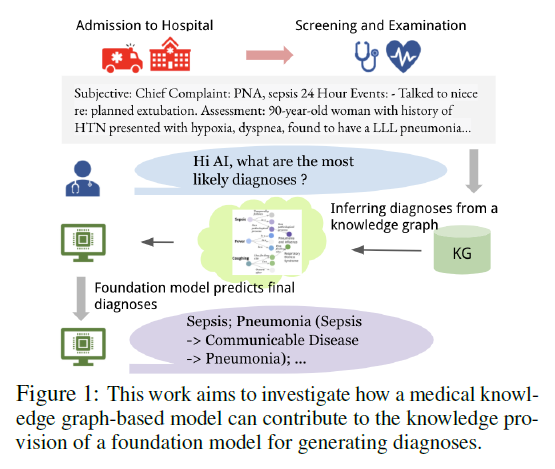

为了应对这些挑战,研究者们提出了一种创新方法,通过引入医学知识图谱(KG),结合一种名为“DR.KNOWS”的图模型,来增强LLMs在自动生成诊断的准确性。该模型基于临床诊断推理过程,旨在帮助LLMs更好地解释和总结复杂的医疗概念,提供一个更准确和可解释的诊断路径。

方法

1. 医学知识图谱构建与来源

医学知识图谱(KG)的构建基于美国国家医学图书馆的统一医学语言系统(UMLS)。UMLS 是一个包含了大量生物医学知识的数据库,它整合了多种医学词汇表,形成了概念和语义关系的知识图谱。UMLS 的概念库包含超过 450 万个概念和 1500 万个关系,这些数据提供了丰富的知识支持。本研究从 UMLS 中提取了医疗概念,并主要使用了系统化医学术语(SNOMED-CT),这一医学词汇标准广泛用于电子健康记录(EHRs)中。

UMLS 的概念词汇包括多个语义类型和网络,帮助有效探索和支持语义理解。研究者们从这些概念和语义关系中构建了一个知识图谱,其节点表示医疗概念,边表示概念间的语义关系。在该图谱上,通过多跳(multi-hop)推理,可以从输入的病人病历信息推断出潜在的诊断结果。

图:根据病人的医疗描述,从 UMLS 知识图谱推断的可能诊断。用彩色方框突出显示 UMLS 医学概念(“女性”、“败血症 ”等)。每个概念都有自己的子图,其中概念是顶点,语义关系是边(由于篇幅限制,在此图中忽略了 “女性 ”的子图)。通过第一跳转,我们可以识别出与输入描述最相关的邻近概念。顶点的颜色越深,说明它们与输入的描述越相关。根据最相关的节点,可以进一步进行第二跳,最终得出 “肺炎和流感 ”和 “呼吸窘迫综合症 ”的诊断结果。

2. DR.KNOWS模型架构设计

2.1 输入与处理

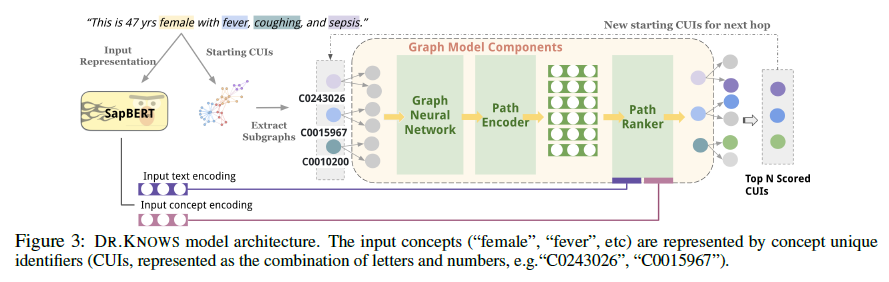

DR.KNOWS 模型接收的输入是来自病人的医疗描述文本,该文本通过医学概念提取工具(如 cTAKES 或 QuickUMLS)解析出相关的 UMLS 概念。这些概念作为知识图谱的输入节点,经过多跳推理生成诊断结果。为了确保推理的高效性,每个 UMLS 概念都分配了唯一的 SNOMED 概念标识符(CUI)。最终形成知识图谱。

2.2 图模型设计

知识图谱中的节点表示医学概念,边则表示概念之间的语义关系。对于每一个输入概念(如病人症状或病史),系统首先进行 1 跳推理,识别该概念的直接邻居节点(与该概念有直接关联的其他概念),这些邻居节点根据与输入描述的相关性进行排序。模型会选出前 N 个最相关的邻居节点,然后继续执行下一跳推理,直到找到最合适的诊断节点。

2.3 模型结构与层次

-

概念编码器(Contextualized Node Representation):对于每个医学概念,使用 SapBERT 编码器(针对 UMLS 进行训练的生物医学概念表示模型)生成概念的上下文表示。首先对每个概念的名称进行编码,然后通过图同构网络(Graph Isomorphism Network, GIN)对概念的邻居节点信息进行迭代聚合。

-

路径选择与排序(Path Reasoning and Ranking):对于每个候选路径,使用注意力机制(MultiHead 或 Trilinear attention)计算路径与输入文本及输入概念的逻辑关联性。该过程会生成一个打分矩阵,最终根据得分选出最相关的 N 个路径。

-

多跳推理(Multi-hop Reasoning):为了在图中寻找诊断路径,DR.KNOWS 使用多跳推理机制,从病人输入信息的初始节点开始,逐步通过图谱上的相关概念进行推理。每一跳中,DR.KNOWS 都会选择前 N 个最相关的节点继续推理,直到最终找到潜在的诊断节点。

3. 路径推理与排序

接下来,模型为每个1跳关系生成路径表示,并通过两种注意力机制进行路径排序——多头注意力机制(MultiHead Attention,MultiAttn)或三线性注意力机制(Trilinear Attention,TriAttn)。这些机制评估路径与输入文本的相关性,并根据得分确定是否继续进行更多跳数的探索,直到找到合适的诊断结点为止,或选择终止探索。

模型使用AdamW优化器进行训练,通过跨多个跳数追踪与诊断相关的概念。使用CUI预测损失函数来提升模型的准确性,通过将预测的CUI与真实值进行对比,不断优化模型性能。

结果

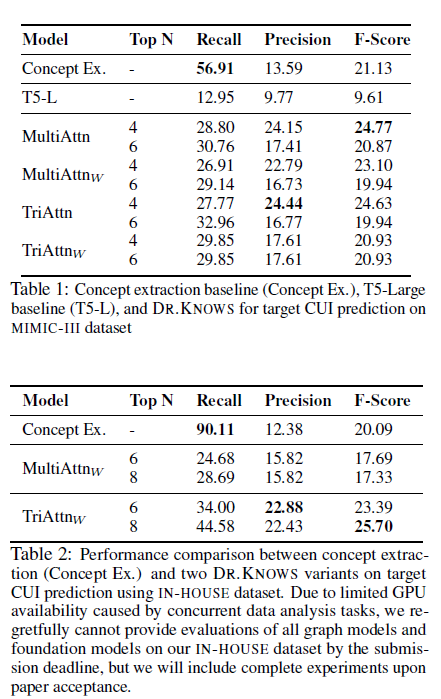

DR.KNOWS模型的性能通过多种指标进行评估,并与基线模型(如T5和QuickUMLS)进行了比较。

1. 诊断生成性能的提升

DR.KNOWS模型通过知识路径生成显著提高了诊断预测的准确性。特别是在CUI(概念唯一标识符)的预测任务中,DR.KNOWS相比于基线模型表现出更高的准确性(Precision)和召回率(Recall),尤其是在多跳路径上的表现更为突出。例如,MultiAttn模型在MIMIC-III数据集上达到的最佳F1得分为24.77,而基线模型的F1得分仅为9.61 。

2. 路径提示的作用

通过将知识路径作为提示输入到大型语言模型(如T5和GPT-3.5)中,模型在生成诊断摘要时表现出更高的性能。无论是在微调还是零样本设置下,路径提示都提高了模型的CUI召回率和准确性。例如,微调后的VanillaT5模型使用路径提示后的CUI F1得分从26.19提升至27.78 。

3. 跨模型的比较

在比较不同模型时,发现ClinicalT5模型对于医学领域数据集(如MIMIC-III)的敏感性较高,尽管其CUI F1得分低于其他版本的T5模型(如VanillaT5和FlanT5),但其使用路径提示后的F1得分依然有所提升 。

结论

本研究提出了一个新颖的基于图谱的模型——DR.KNOWS,用于从患者的进展记录中识别可能的诊断。DR.KNOWS模型通过多跳路径选择出前N个最有可能的诊断,优于传统的概念提取和T5基线模型。通过使用这些路径作为提示对T5模型进行微调,并结合路径驱动的零样本提示对ChatGPT进行诊断预测,结果显示利用知识路径能显著提高诊断预测的准确性。手动分析还表明,ChatGPT在推理和解释诊断结论时有效地利用了这些路径。

该研究展示了将知识图谱与语言模型结合,能够有效提高诊断生成的准确性和可解释性,并为未来在医疗诊断生成领域的进一步研究提供了方向。

最后的最后

感谢你们的阅读和喜欢,我收藏了很多技术干货,可以共享给喜欢我文章的朋友们,如果你肯花时间沉下心去学习,它们一定能帮到你。

因为这个行业不同于其他行业,知识体系实在是过于庞大,知识更新也非常快。作为一个普通人,无法全部学完,所以我们在提升技术的时候,首先需要明确一个目标,然后制定好完整的计划,同时找到好的学习方法,这样才能更快的提升自己。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

大模型知识脑图

为了成为更好的 AI大模型 开发者,这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

经典书籍阅读

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献34条内容

已为社区贡献34条内容

所有评论(0)